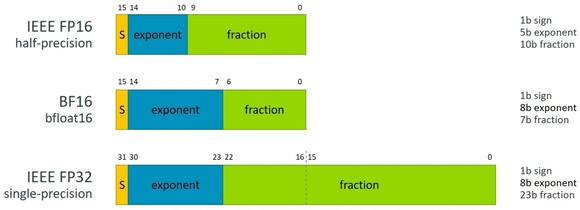

Az ARM bejelentette, hogy az ARMv8-A utasításarchitektúra új revíziójába beépítik a BFfloat16 adattípus natív támogatását, ami a gépi tanulás tréning szakasznál lehet hasznos. Ennek az az előnye, hogy az 32 bites lebegőpontos adattípussal megegyezően 8 bites exponenst használ, viszont a mantissza 23 bit helyett csak 7 bites. Ezzel természetesen a pontosság csökken, viszont a gépi tanulás tekintetében ez így is kedvezőbb a normál 16 bites lebegőpontos adattípushoz viszonyítva, miközben a BFfloat16 teljesítményelőnye a 32 bites operációkhoz viszonyítva nagyon hasonló.

Az újítás egyértelműen a szerverpiacot célozza, mellé pedig új SVE és NEON utasítások is érkeznek, konkrétan négy: BFDOT, BFMMLA, BFMLAL és BFCVT. Ezek tulajdonképpen a BFfloat16 adattípus megfelelő kihasználáshoz kellenek.

Az ARM ezzel a lépéssel szorosan követi az Intel Cooper Lake kódnevű, jövőre érkező fejlesztését a BFfloat16 támogatás szempontjából. Arról egyelőre nincs pontos információ, hogy pontosan melyik fejlesztés alatt álló, Neoverse dizájnban érkezik ez az újítás.