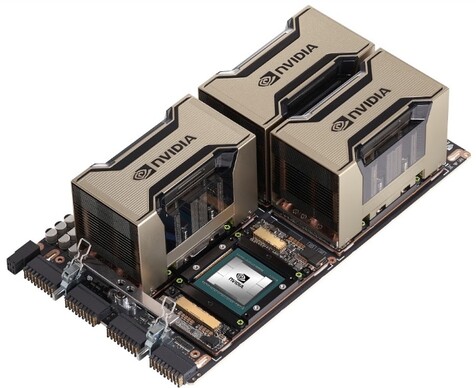

Az NVIDIA hamarosan leleplezi az A100 jelzésű gyorsítót. Ez az esemény hamarabb is megtörtént volna, de az új koronavírus-járvány keresztbe tett a terveknek. A vállalat az idei GTC-t virtuális formában tartja meg, a bejelentéseket pedig tulajdonképpen hamarabb megejtik, így a prezentáció idejére felkészülhetnek az érdeklődők.

A cég az első, Ampere architektúrára épülő lapkáról fog majd beszélni, amely rendkívül méretes, 826 mm² GPU lesz, és ebbe 54,2 milliárd tranzisztort sikerült bepréselni a TSMC valamelyik 7 nm-es node-ját felhasználva.

A fedélzeti tár HBM2 szabványú memóriára épül. Fizikailag 6144 bites memóriabusz van kiépítve, de az A100 esetében nem mindegyik 1024 bites csatorna lesz bekapcsolva, vagyis 40 GB-nyi fedélzeti tárral lehet majd számolni, amelyek 5120 bites buszon keresztül kapcsolódnak a GPU-hoz. A memória-sávszélesség így 1,555 TB/s lesz, amit 2,43 GHz-es effektív órajelen működő HBM2 memóriákkal érnek el.

Az NVIDIA az Ampere architektúra tervezésében mindent a gépi tanulásnak rendelt alá. Nem véletlenül hívják a rendszert Tensor Core GPU-nak. A normál feldolgozókat tekintve nincs jelentős ugrás, hiszen 6912 darab, 32 bites lebegőpontos feldolgozást támogató CUDA mag található benne. Ezek natívan kezelik felezett pontosságot, míg a dupla pontosságról további 3456 mag gondoskodik. Vagyis a szimpla pontosság melletti 19,5 TFLOPS-os teljesítmény felezett és dupla pontossággal rendre 39 és 9,7 TFLOPS lesz. A GPU Boost órajel 1575 MHz lesz, de ez az előbbi adatok alapján kiszámolható.

Ha a korábbi generációs Volta architektúrához nézzük a változást, akkor nagyjából 30%-os az előrelépés a nyers teljesítményt tekintve, de nem véletlenül hívja ezt a hardvert Tensor Core GPU az NVIDIA, ugyanis a gépi tanulás egyik tipikus problémája, hogy a GPU-k nem igazán hatékonyak benne. Itt nem arra kell gondolni, hogy nem végzik jól a probléma nagy részét kitevő mátrixszorzást, hanem sokkal jobb hatásfokú dizájnok is építhetők, amelyek magasan rávernek a GPU-kra. Ezért vezette be az NVIDIA a tenzorfeldolgozókat a Volta architektúrában. Ugyanakkor ezzel a lépéssel válaszút elé is került a cég: vagy az egyik irányba megy, vagy a másikba. A tenzorfeldolgozók előnye, hogy hihetetlenül jók gépi tanulásban, de csapnivalók a grafikai munkákat tekintve. Egyszerűen arra lettek tervezve, hogy a mátrixszorzást félelmetesen gyorsan oldják meg, cserébe minden másban rém gyengék. A fentiek miatt van az, hogy a vállalat modernebb architektúráiban mindkét feldolgozódizájn megtalálható, az egyik a gépi tanulásra, a másik pedig grafikai és általános számításokra, utóbbi két irány például jól átlapolja egymást.

Az A100 számítási teljesítménye tehát első hallásra furának tűnhet, hiszen 30%-ot gyorsult a Tesla V100-hoz képest, de nagyon fontos, hogy dizájnból ilyen az Ampere architektúra, és ezért hangsúlyozza az NVIDIA a Tensor Core GPU elnevezést rá. Ha ugyanis számításba vesszük a gépi tanulást, akkor igen komoly kis szörnyeteg született. Erről 432 darab tenzor mag gondoskodik, amely szám szerint visszalépésnek tűnik a Volta architektúrához viszonyítva, de valójában ezeknek a feldolgozóknak már más a felépítésük, így sokkal többre képesek, mint a korábbi generációs dizájnok. Többek között támogatják a 4 és 8 bites integer, illetve a 16, 32 és 64 bites lebegőpontos operációkat. Némelyiket több formátumon keresztül is, például 16 bit esetében bfloat16 adattípus, ami a 32 bites lebegőpontos adattípussal megegyezően 8 bites exponenst használ, viszont a mantissza 23 bit helyett csak 7 bites. A számítási kapacitás tekintetében itt lesznek komoly ugrások, mivel INT4 és INT8 adattípusnál 1248 és 624 TOPS tempóra lehet számítani, míg TF16 vagy bfloat16 esetében 312 TFLOPS áll rendelkezésre, TF32 és FP64 Tensor Core mellett pedig rendre 156 és 19,5 TFLOPS-ra képes az új fejlesztés. Mindezek mellett az úgynevezett structural sparsity támogatással az előbb említett értékek duplája is elérhető, kivéve az FP64 Tensor Core esetében.

Gépi tanulásban tehát hatalmas, konkrétan sokszoros az előrelépés, és ez lényeges az NVIDIA számára, mert egyre több, kifejezetten AI-ra kialakított chipdizájn készül a piacon, amelyeknél semennyi tranzisztort nem költenek el grafikai vagy általános számításokra való optimalizálásra, tehát ezek nyomába a zöldek is csak célirányos dizájnnal tudnak eredni. Tulajdonképpen ez az Ampere architektúra lényege, már a koncepció szintjén a gépi tanulásra fókuszálni.

Az A100 a Tesla V100-hoz és P100-hoz hasonló dizájnban érkezik, így rendkívül kritikus az NVLink interfész, illetve az SXM formátum, utóbbinak is a negyedik verziója. A friss GPU-ban 12 darab, kétirányú kommunikációra képes, harmadik generációs NVLink található, így összesen 600 GB/s biztosított. A lapkák összeköttetése szempontjából több lehetőség van. Négy GPU-ig elég szimplán az NVLINK-et használni, míg nyolc GPU-nál már NVSwitch is kell. A host processzor felé x16-os PCI Express 4.0-s interfész áll rendelkezésre, de opcionálisan itt is lehet élni az NVLinkkel, ha az adott CPU képes natívan támogatni. A fogyasztás tekintetében egyébként az A100 új szintet üt meg, ugyanis 400 wattos energiaigénnyel rendelkezik. Ez ugyanakkor az SXM formátumot tekintve nem számít igazán hátránynak.

NVIDIA HGX A100 4-GPU connected with NVLink és HGX A100 8-GPU connected with NVSwitch [+]

NVIDIA HGX A100 4-GPU connected with NVLink és HGX A100 8-GPU connected with NVSwitch [+]

Az NVIDIA bejelentette két szerverplatformot is: HGX A100 8-GPU connected with NVSwitch és HGX A100 4-GPU connected with NVLink. A nevük igazán beszédes, előbbi nyolc GPU-s rendszer NVSwitch összeköttetéssel, míg utóbbi négy GPU-s megoldás szimplán NVLinkkel, de ezekről a lehetőségekről az előző bekezdésben már szó volt.

A vállalat dolgozik azon, hogy az A100-as még az idei évben elérhetők legyen a partnereik számára. Az Ampere architektúráról a későbbiekben beszélnek majd bővebben, de már most tudni, hogy készül egy grafikai és általános számításokra is kihegyezett dizájn, mivel az A100-ba került verzió ezekben pont nem jeleskedik, de mivel a fentebb részletezett fejlesztést a gépi tanulásra szánják, így a célpiacokat nem is érdekli, hogy miben nem jó.